오픈 AI의 대화형 인공지능(AI) 챗(Chat)GPT-4가 안과 시험에서 인간 전문의에 필적하는 점수를 냈다. 전문 분야에서 방대한 지식을 쌓은 대규모 언어 모델(LLM)의 놀라운 능력에 학계 관심이 쏠렸다.

영국 케임브리지대학교 등이 참여한 국제 연구팀은 17일 학술지 플로스원 디지털 헬스(PLOS Digital Health)에 낸 조사 보고서에서 이같이 전했다.

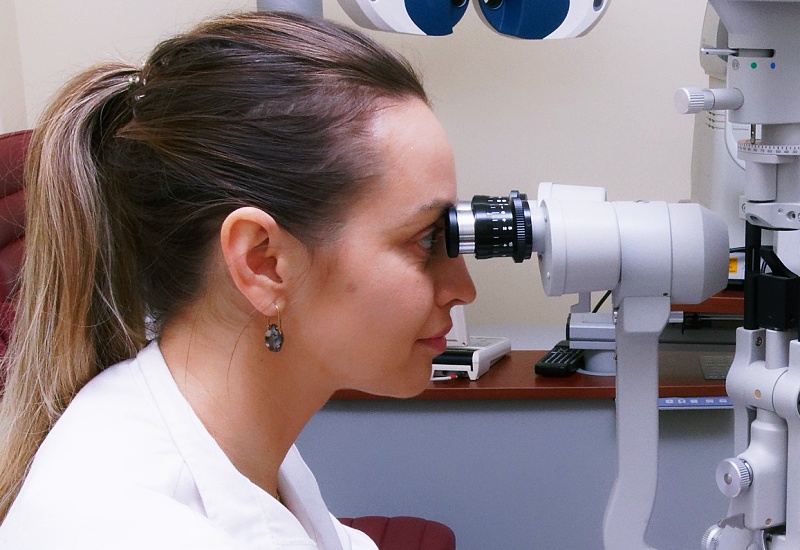

AI는 2018년 인간 의사와 동등한 정확도로 눈병을 진단하는 수준까지 진보했다. 현재 AI는 당뇨병이 야기하는 눈병을 전문의 수준으로 파악한다. 연구팀은 안과 분야에서 언어 AI 모델이 어떤 수준으로 눈의 상태를 진단하는지 알아보기 위해 실험했다.

연구팀은 오픈 AI의 GPT-3.5와 GPT-4, 구글의 PaLM2, 메타의 라마(LLaMA)를 대상으로 총 87개 안과 문제를 출제했다. 각 문항은 안과 전문의 자격을 따기 위해 수련의가 응시하는 FRCOphth part2 교재에서 발췌했다.

케임브리지대 윌리엄 폴 포스터 연구원은 "해당 교재는 인터넷에 공개되지 않아 AI가 미리 학습할 가능성이 낮다"며 "이미지 등 텍스트 이외의 요소가 포함된 문제를 제외한 87개 문항을 안과 전문의 5명, 안과 수련의 3명, 안과 비전공의 2명 및 AI에 풀게 했다"고 전했다.

그 결과, GPT-4는 87문제 중 60문제를 맞혀 안과 수련의 평균점인 59.7점을 근소하게 앞섰다. 안과 전문의 평균점 66.4점에는 미치지 못했지만 이들 중 가장 낮은 점수인 56점은 앞섰다. PaLM2는 49점, GPT-3.5는 42점으로 안과를 전공하지 않은 의사의 평균 점수 37점을 웃돌았다. AI 중 최저점을 낸 것은 라마(28점)였다.

포스터 연구원은 "GPT-4는 순수한 지식을 묻는 문항은 물론 정보의 해석과 처리 등 고도의 추론을 필요로 하는 문제에도 강했다"며 "이 연구를 통해 눈 건강에 관한 대규모 언어 모델의 지식과 추론 능력은 전문가와 거의 구별되지 않는 것이 입증됐다"고 말했다.

그간 안과 분야의 AI 테스트는 눈 스캔 이미지 분석 등 한정적인 능력을 테스트하는 데 그쳤다. 이번에는 AI와 현역 의사의 능력을 직접 비교했다는 점에서 학계의 관심이 쏠렸다.

포스터 연구원은 "베테랑 의사도 놓칠 수 있는 초기 유방암을 감지하는 등 AI가 질병 진단에 도움이 된다는 사실은 속속 증명되고 있다"며 "다만 AI는 잘못된 정보를 그럴듯하게 전하는 환각 문제가 여전해 의료 현장에 완전히 도입하기 위해서는 이번처럼 새로운 연구가 더 필요하다"고 강조했다.

정이안 기자 anglee@sputnik.kr